- Что такое индексация сайта

- Как индексирует сайты Гугл и Яндекс

- Проверяем индексацию

- Как ускорить индексацию сайта

- Как закрыть сайт от индексации

- На что влияет индексация при продвижении

- Индексация сайта в Google и Яндекс: почему сайт не индексируется

- Что значит индексация сайта и почему она важна

- Как происходит индексация сайта

- Сканирование страниц

- Обработка страниц

- Как проверить индексацию

- Поисковая строка

- Бесплатные плагины

- Веб-сервисы Яндекс.Вебмастер и Google Search Console

- Управление индексацией сайта

- Что делать, если сайт не индексируется

- Технические причины

- Контентные причины

- Иные причины

- Заключение

Что такое индексация сайта

11 декабря 2017 Опубликовано в разделах: Азбука терминов. 31697

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Индексация сайта значит, что робот поисковой системы посещает ресурс и его страницы, изучает контент и заносит его в базу данных.Впоследствии эта информация выдается по ключевым запросам. То есть, пользователи сети вводят в строку поиска запрос и получают на него ответ в виде списка проиндексированных страниц.

Если говорить простым языком, получится приблизительно так: весь интернет — это огромная библиотека. В любой уважающей себя библиотеке есть каталог, который облегчает поиск нужной информации. В середине 90-х годов прошлого века, вся индексация сводилась к такой каталогизации. Роботы находили на сайтах ключевые слова и формировали из них базу данных.

Сегодня боты собирают и анализируют информацию по нескольким параметрам (ошибки, уникальность, полезность, доступность и проч.) прежде, чем внести ее в индекс поисковой системы.

Алгоритмы работы поисковых роботов постоянно обновляются и становятся все сложнее. Базы данных содержат огромное количество информации, несмотря на это поиск нужных сведений не занимает много времени. Это и есть пример качественной индексации.

Если сайт не прошел индексацию, то информация до пользователей может и не дойти.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

- Добавить сайт на индексацию при помощи ссылок на других ресурсах в интернете — этот способ считается оптимальным, так как страницы, найденные таким путем, робот считает полезными и их индексирование проходит быстрее, от 12 часов до двух недель.

- Отправить сайт на индексацию путем заполнения специальной формы поисковой системы вручную с использованием сервисов Яндекс.Вебмастер, Google Webmaster Tools, Bing Webmaster Tools и др.

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

- поисковый робот находит портал и изучает его содержимое;

- полученная информация заносится в базу данных;

- примерно через две недели материал, успешно прошедший индексацию, появится в выдаче по запросу.

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

- при помощи инструментов для вебмастеров — google.com/webmasters или webmaster.yandex.ru;

- при помощи ввода специальных команд в поисковую строку, команда для Яндекс будет выглядеть так: host: имя сайта+домен первого уровня; а для Гугл — site: имя сайта+домен;

- с помощью специальных автоматических сервисов.

Проверяем индексацию

Это можно сделать используя:

Как ускорить индексацию сайта

От того, насколько быстро роботы проведут индексирование, зависит скорость появления нового материала в поисковой выдаче, тем быстрее на сайт придет целевая аудитория.

Для ускорения индексации поисковыми системами нужно соблюсти несколько рекомендаций.

- Добавить сайт в поисковую систему.

- Регулярно наполнять проект уникальным и полезным контентом.

- Навигация по сайту должна быть удобной, доступ на страницы не длиннее, чем в 3 клика от главной.

- Размещать ресурс на быстром и надежном хостинге.

- Правильно настроить robots.txt: устранить ненужные запреты, закрыть от индексации служебные страницы.

- Проверить на наличие ошибок, количество ключевых слов.

- Сделать внутреннюю перелинковку (ссылки на другие страницы).

- Разместить ссылки на статьи в социальных сетях, социальных закладках.

- Создать карту сайта, можно даже две, — для посетителей и для роботов.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

- При помощи robots.txt можно запретить индексацию сайта или страницы. Для этого в корне веб-сайта создается текстовый документ, в котором прописываются правила для роботов поисковых систем. Эти правила состоят из двух частей: первая часть (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию какого-либо объекта.

Например, запрет индексации всего сайта для всех поисковых ботов выглядит так:

User-agent: *

Disallow: /

- При помощи мета-тега robots, что считается наиболее правильным для закрытия одной страницы от индексирования. При помощи тегов noindex и nofollow можно запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Запись для запрета индексации всего документа будет выглядеть так:

Можно создать запрет для конкретного робота:

На что влияет индексация при продвижении

Благодаря индексации сайты попадают в поисковую систему. Чем чаще обновляется контент, тем быстрее это происходит, так как боты чаще приходят на сайт. Это приводит к более высокой позиции при выдаче на запрос.

Индексация сайта в поисковых системах дает приток посетителей и способствует развитию проекта.

Кроме контента, роботы оценивают посещаемость и поведение посетителей. На основании этих факторов они делают выводы о полезности ресурса, чаще посещают сайт, что поднимает на более высокую позицию в поисковой выдаче. Следовательно, трафик снова увеличивается.

Индексация — это важный процесс для продвижения проектов. Чтобы индексирование прошло успешно, поисковые роботы должны убедиться в полезности информации.

Алгоритмы, по которым работают поисковые машины, постоянно меняются и усложняются. Цель индексации — внесение информации в базу данных поисковых систем.

Источник

Индексация сайта в Google и Яндекс: почему сайт не индексируется

Чтобы пользователи узнали о вашем сайте и, к примеру, совершили покупку или прочитали статью — он должен отображаться в поисковых системах, вроде Google и Яндекс. Для этого каждый ресурс проходит индексацию. Этот процесс отличается от ранжирования тем, что при индексации сайт просто попадает в базу данных поисковиков, а при ранжировании — встает на конкретное место.

Мы спросили мнение у экспертов в области веб-оптимизации и рассказали в статье о том, как происходит индексация сайтов и что делать, если ваши страницы не индексируются поисковиками.

Что значит индексация сайта и почему она важна

«Индексирование сайта — это процесс, в ходе которого поисковые системы получают информацию о страницах ресурса. Полученные данные хранятся в базе, которую называют поисковым индексом. Так Яндекс, Google и другие поисковики узнают, что ваш сайт существует и наполнен полезным контентом. Индексация нужна для того, чтобы юзеры могли найти ваши страницы при поиске» — так определяет индексацию Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group.

Эксперт Роман Огрин добавляет, что индексация — важный этап запуска любого проекта, на котором планируется активное SEO-продвижение или есть планы по развитию органического трафика. Исключения составляют рекламные форматы, вроде контекстной рекламы, — для них процесс индексации не является ключевым.

Для индексирования поисковик, например Яндекс или Google, отправляет на сайт роботов, они считывают код и регулярно посещают страницы ресурса. Периодичность зависит от того, как часто меняется контент, от количества страниц и объема трафика.

Как происходит индексация сайта

Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс, сравнивает индексацию с добавлением книги в библиотеку: когда определен жанр, автор и название книги, она занимает свое место в библиотеке, и читатель может ее найти. Поэтому индексацию сайта вернее рассматривать как двухэтапный процесс: сначала идет сканирование страниц, затем — их обработка.

Сканирование страниц

Сканирование страниц — это основная задача поискового робота. Когда он попадает на новую страницу, то получает два набора данных:

- Содержание, информацию о сервере и служебные данные.

- Перечень ссылок на страницах.

Затем робот передает данные в обработку, а после — сохраняет в базе. Самый простой способ индексации страниц в рамках домена — создание карты сайта sitemap.xml.

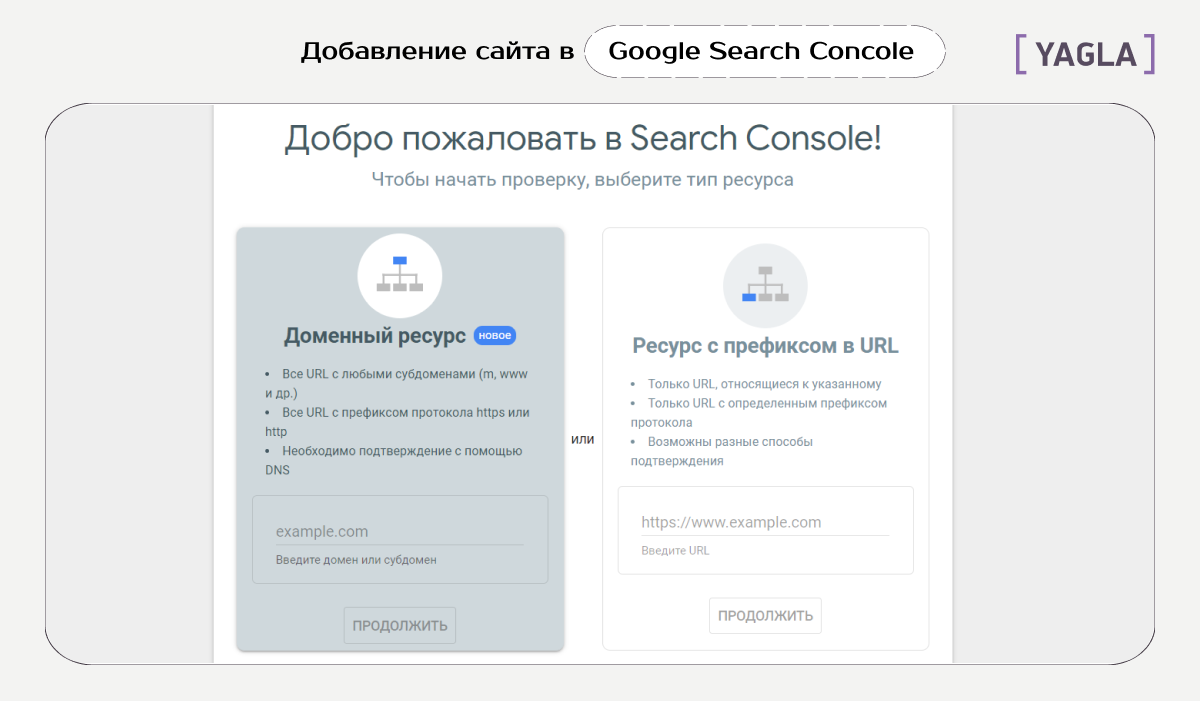

Чтобы Google и Яндекс увидели ваш сайт, нужно cначала добавить его в сервисы, а затем прикрепить ссылку на файл Sitemap в Google Search Console и Яндекс.Вебмастере. Это специальные сервисы для веб-мастеров, которые помогают работать с индексацией.

Чтобы добавить файл Sitemap в Google Search Console, зайдите в сервис, добавьте свой сайт и перейдите в раздел «Сканирование». В пункте «Файлы Sitemap» выберите «Добавить файл Sitemap» и вставьте ссылку на файл Sitemap.

В Яндекс.Вебмастере путь похож: зайдите в ваш аккаунт, выберите нужный сайт. Затем в левом меню нажмите на раздел «Индексирование» и выберите вкладку «Файлы Sitemap». В строку «Добавить файл Sitemap» вставьте ссылку файла и нажмите «Добавить». Кстати, если вы внесли изменения в карту сайта, то просто отправьте карту на перепроверку, нажав на стрелочки рядом с файлом Sitemap.

Обработка страниц

После сбора роботами информация проходит обработку и потом попадает в базу данных. Это необходимо для ускорения дальнейшего поиска.

В начале программа формирует страницу со всем содержимым: скрипты, эффекты, стили. Важно, чтобы робот имел полный доступ ко всем файлам, потому что без них индексатор не сможет понять структуру.

Вы можете посмотреть, одинаково ли видят страницу пользователи и поисковой робот. Для этого зайдите в Google Search Console, выберите отчет «Посмотреть как Googlebot» в разделе «Сканирование».

Затем робот анализирует текст страницы: упрощает слова и определяет частоту упоминания ключевого слова, проверяет уникальность. Так, если ваш контент уже индексировали в интернете, то у страниц будет низкая уникальность. Значит, робот может не добавить их в поисковый индекс. Поэтому важно наполнять свой сайт уникальным и полезным контентом.

Как проверить индексацию

Эксперты выделяют три способа, чтобы проверить, отображается ли сайт в поисковиках: запрос в поисковой системе, использование бесплатных сервисов для автоматической проверки и использование сервисов для веб-мастеров.

Поисковая строка

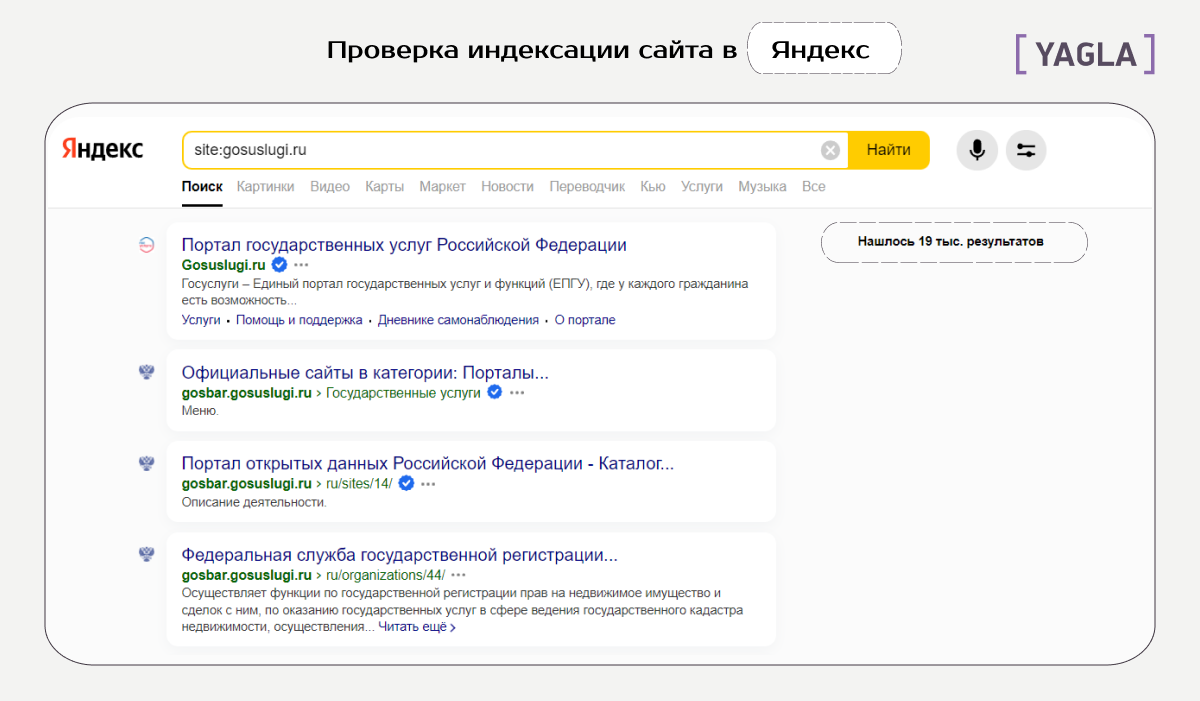

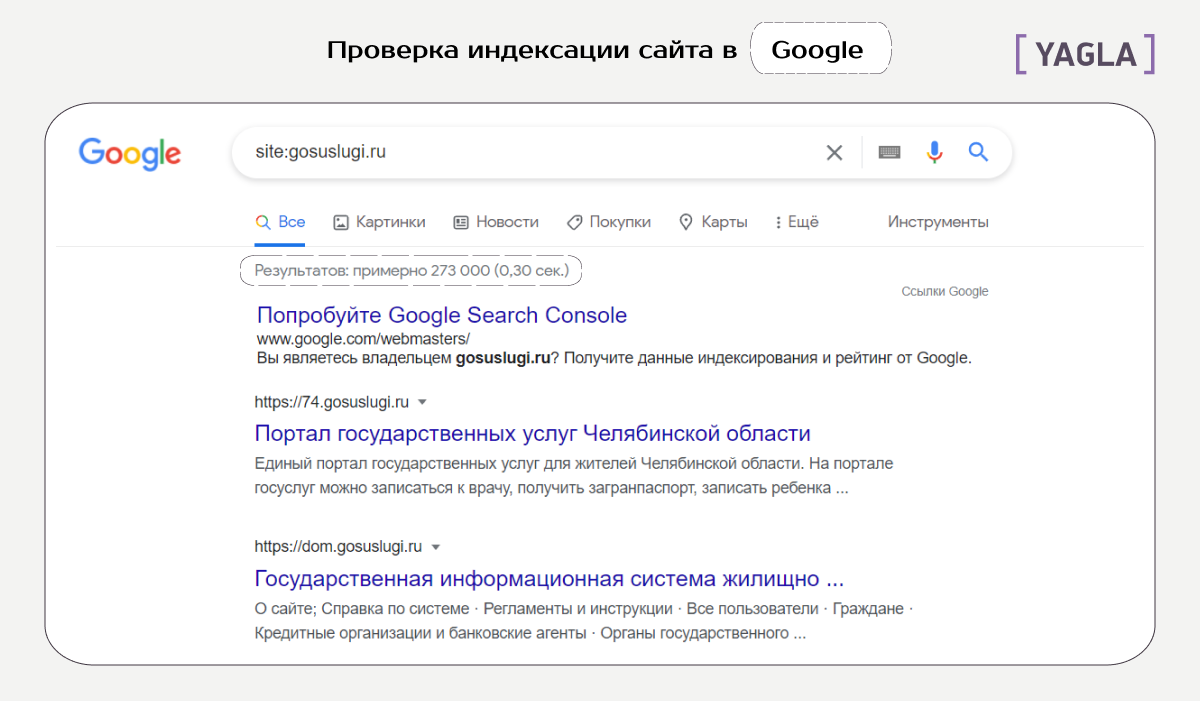

Роман Огрин, руководитель группы оптимизации в Kokoc Group, называет специальные операторы самым быстрым и простым способом проверки индексации. Яндекс и Google поддерживают оператор site, который помогает отображать проиндексированные страницы. Базовый синтаксис использования: site:sitename.com

Но поисковые системы могут ограничить работу этих операторов для снижения нагрузки. Поэтому рекомендуют использовать дополнительные способы для проверки индексации.

Бесплатные плагины

«Можно использовать специальные бесплатные сервисы, например, be1.ru и pr-cy.ru. Для проверки введите адрес сайта в специальную строку и нажмите «Проверить». Обычно такие сервисы, помимо количества страниц в индексе популярных поисковиков, предоставляют еще много интересных данных» — Николай Полушкин, директор веб-студии DIUS.

Веб-сервисы Яндекс.Вебмастер и Google Search Console

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, считает веб-сервисы поисковых систем самым достоверным источником информации о наличии страницы в индексе. В этих инструментах можно получить данные о количестве, динамике индексации, причинах удаления или включения страницы в базу данных, а также многое другое. Минус в том, что доступы к этой информации могут получить только владельцы сайта или те, у кого есть права владельцев.

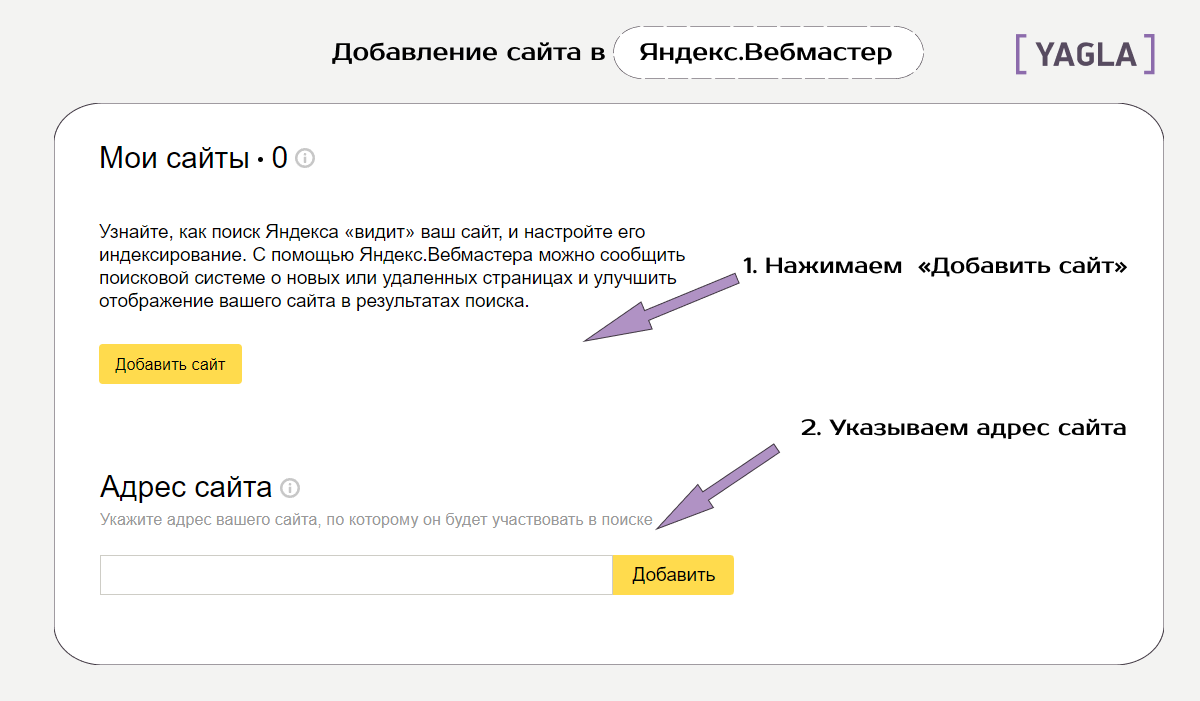

Эксперт Роман Огрин рассказывает, как именно посмотреть индексацию в Яндекс.Вебмастере и Google Search Console. Оба сервиса сначала надо «привязать» к исследуемому домену и только потом смотреть точную статистику.

В Яндекс.Вебмастере есть раздел «Индексирование» с подразделом «Страницы в поиске». По клику на вкладку «Все страницы» сервис выдает список проиндексированных на данный момент документов. В Search Console аналогичный инструмент — отчет «Покрытие».

Помимо простого анализа страниц в индексе, оба сервиса предоставляют много полезной статистики. Эта информация поможет сделать правильные выводы при проблемах с индексацией.

Например, посмотрите, совпадает ли количество проиндексированных страниц с количеством страниц вашего сайта. Если у вас 240 страниц, а в индексе только 100, это означает, что есть проблемы с индексацией, ведь поисковая система не знает о большей части контента.

Управление индексацией сайта

Вы можете сами задать параметры индексирования для роботов поисковых систем. Например, настройка канонического адреса необходима, если есть страницы с одинаковым содержанием. Она позволяет указать, какая из них приоритетна для индексации.

Текстовый файл robots.txt также позволяет управлять поисковыми роботами с помощью директив.

- Директива Disallow закрывает сайт или конкретные страницы от индексации роботами.

- User-Agent указывает поисковую систему для индексации по написанной инструкции.

- Crawl-delay задает частоту обращения роботов к ресурсу. Работает для Яндекса.

- Clean-param закрывает индексирование с конкретными динамическими параметрами.

- Директива Allow разрешает роботам индексирование отдельных страниц.

Что делать, если сайт не индексируется

Есть множество причин, почему сайт не индексируется. Эксперт Сергей Шабуров условно разделяет причины на технические и контентные. Ниже рассмотрим основные из них с примерами из опыта специалистов.

Технические причины

Сайт может быть случайно закрыт от сканирования роботами или из-за ошибки разработчиков. Это можно определить, если проверить:

- Директиву Disallow в файле robots.txt. Как мы писали выше, эта директива закрывает конкретные страницы от индексации.

- Мета-теги в разделе HTML-документа, например, . Они определяют отношение к сканированию контента в документе.

- HTTP-заголовок X-Robot-Tag — информация о запрете или разрешении индексации сайта в HTTP-заголовках ответа сервера.

- Код ответа сервера. В индекс попадают только доступные страницы с кодом ответа сервера 200 Ок, а ресурсы с другими кодами ответа удаляются. Изменение кода ответа — один из способов управления индексацией.

- Настройки сервера. Для разных IP адресов, User-agent и других параметров серверная часть ресурса может регулировать как скорость, так и саму отдачу информации о странице и ее содержимом.

- Наличие входящих внутренних или внешних ссылок. Индекс может исключать такие страницы.

- Низкий трафик. Это может быть следствием малополезной страницы или отсутствием семантического спроса со стороны пользователей по данному контенту.

Николай Полушкин, директор веб-студии DIUS, делится недавним случаем из практики. «Пришел сайт на бесплатный аудит. Клиент жаловался на резкую просадку трафика. SEO-специалист сразу открыл файл robots.txt и нашел строчку Disallow. Мы сообщили об этом клиенту и объяснили, что сайт закрыт от индексации, и страницы постепенно удаляются из поиска. Заказчик был удивлен и попросил выяснить, кто и когда это сделал. Недавно компания делала редизайн и наш специалист предположил, что страницы на время работ закрыли от индексации, а потом забыли убрать запрещающую директиву».

Контентные причины

Важно помнить, что индексация занимает некоторое время. Поэтому, если страницы нет в индексе, иногда это может значить, что роботы поисковых систем не успели до нее дойти. Либо есть ошибки в контентном наполнении страниц:

- Отсутствие индексируемого контента. Контент может быть реализован на технологии, которую поисковые системы не умеют считывать или плохо воспринимают к индексации. Так векторная графика, например Flash, не индексируется.

- Контент без пользы или вредный для пользователей. Сюда относят: спам, малый по объему контент, устаревшая информация, которая никогда не будет востребована, наличие вирусов, фишинга.

- Дублирующийся контент. Поисковые системы стараются не индексировать или удалять из выдачи страницы, которые содержат повторяющуюся информацию.

«У нас была такая ситуация с кулинарной онлайн-школой. В Google сайт показал хорошие результаты уже в первый месяц работы и вышел в ТОП-3 по прямым запросам. Но в Яндексе страницы вообще отсутствовали.

Чтобы узнать причину, мы зарегистрировали сайт в Яндекс.Вебмастере и отправили на проверку. Результаты показали критическую ошибку. Дело было в том, что на ресурсе дублировались страницы. Владельцы школы публиковали для разных таргетологов страницы с одинаковым контентом, но разными ссылками. Яндекс видел в этом неуникальный контент и не индексировал страницы.

Мы удалили дублирующиеся страницы, перейдя на utm-метки, и отправили сайт на переиндексацию. Через несколько дней проблема решилась, сайт стал отображаться в Яндексе» — Дарья Каблаш, основатель маркетингового агентства Dvizh.

Иные причины

Более редкие случаи неиндексации могут быть связаны, например, с фильтром «для взрослых».

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, приводит свежий пример из практики. «Сайт одного из российских операторов мобильной связи перестал ранжироваться по навигационному запросу: » тарифы» в Яндексе. В выдаче присутствовали побочные сайты, а ресурс оператора отсутствовал. Это неслыханная вещь, при учете, что целевая страница и все остальные были в индексе по данным Яндекс.Вебмастера. По данному запросу сайт должен был занимать как минимум несколько строчек поисковой выдачи. Проблема выявилась при переключении настроек поиска с умеренного фильтра на фильтр без ограничений.

Это значит, что страница перешла из основного индекса в специальный “Фильтр для взрослых” или «Adult-фильтр». После обращения в службу поддержки Яндекса обнаружилось, что это ошибка на стороне поисковой системы, так как на странице не было какой-либо специфичной информации».

Также возможен редкий случай неиндексации — «плохая история» домена. В этом случае был куплен домен, на котором ранее был поисковый спам или adult-ресурс, поэтому сайт сразу может быть под фильтром.

«В нашей практике был пример сайта на домене, на котором ранее был размещен белый каталог сайтов. Ресурс индексировался нормально и потом резко пропадал из индекса поисковых систем. Помогли письма в техподдержку Яндекса и отправка страниц на принудительную переиндексацию. Но даже после этого периодически сайт продолжал полностью вылетать из индекса, за этим приходилось отдельно следить. Чтобы таких моментов не было, перед покупкой домена лучше всего проверять его историю» — Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс.

Заключение

Без индексации пользователи не увидят ваш сайт даже при прямом поисковом запросе. Поэтому индексация — обязательный процесс для ресурсов, которым важен органический трафик.

Во время индексации роботы сканируют и обрабатывают информацию на страницах, заносят ее в специальную базу данных — поисковый индекс. Можно легко проверить, есть ли ваши страницы в поисковой выдаче, например, в Google. Самый надежный способ — использование сервисов для веб-мастеров: Яндекс.Вебмастер и Google Search Console.

Часто сайты, которые должны быть проиндексированы, все равно не попадают в поиск. В таком случае нужно проанализировать возможные технические и контентные причины. В редких случаях работы могут убрать ресурс из выдачи из-за ошибки на стороне поисковой системы или плохой истории домена.

Источник